*《Debiased Contrastive Learning》">No 1. *《Debiased Contrastive Learning》

技术背景:

Motivation & Framework

很多研究者认为,深度学习的本质就是做两件事情:Representation Learning(表示学习)和 Inductive Bias Learning(归纳偏好学习)。目前的一个趋势就是,学好了样本的表示,在一些不涉及逻辑、推理等的问题上,例如判断句子的情感极性、识别图像中有哪些东西,AI 系统都可以完成非常不错;而涉及到更高层的语义、组合逻辑,则需要设计一些过程来辅助 AI 系统去分解复杂的任务,ICLR 19 的一篇 oral 就是做的类似的事情。因为归纳偏好的设计更多的是 任务相关的,复杂的过程需要非常精心的设计,所以很多工作都开始关注到表示学习上,NLP 最近大火的预训练模型,例如 BERT,就是利用大规模的语料预训练得到文本的好的表示。那么,CV 领域的 BERT 是什么呢?答案已经呼之欲出,就是对比学习。

Illustrative Example

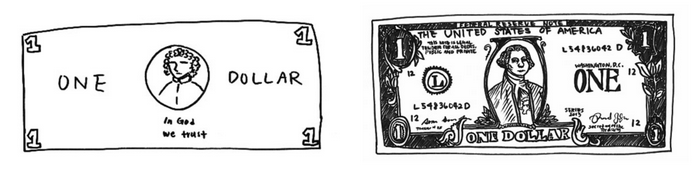

当你被要求画一张美元,左边是没有钞票在你面前,右边是面前摆着一张钞票画出来的结果

上面这个例子来自于 Contrastive Self-supervised Learning 这篇 Blog,表达的一个核心思想就是:尽管我们已经见过很多次钞票长什么样子,但我们很少能一模一样的画出钞票;虽然我们画不出栩栩如生的钞票,但我们依旧可以轻易地辨别出钞票。基于此,也就意味着表示学习算法并不一定要关注到样本的每一个细节,只要学到的特征能够使其和其他样本区别开来就行,这就是对比学习和对抗生成网络(GAN)的一个主要不同所在。

Contrastive Learning Framework

既然是表示学习,那么我们的核心就是要学习一个映射函数 $f$ ,把样本 $x$ 编码成其表示 $f(x)$ ,对比学习的核心就是使得这个 $f$ 满足下面这个式子:

$$s ( f(x), f(x^+)) >> s ( f(x), f(x^-))$$

这里的 $x^+$ 就是和$x$类似的样本, $x^-$ 就是和$x$不相似的样本, $s(\cdot,\cdot)$ 这是一个度量样本之间相似程度的函数,一个比较典型的 score 函数就是就是向量内积,即优化下面这一期望:

$$\underset{x, x^{+}, x^{-}}{\mathbb{E}}\left[-\log \left(\frac{e^{f(x)^{T} f\left(x^{+}\right)}}{e^{f(x)^{T} f\left(x^{+}\right)}+e^{f(x)^{T} f\left(x^{-}\right)}}\right)\right]$$

如果对于一个 $x$ ,我们有 $1$ 个正例和 $N-1$ 个负例,那么这个 loss 就可以看做是一个 N 分类问题,实际上就是一个交叉熵,而这个函数在对比学习的文章中被称之为 InfoNCE。事实上,最小化这一 loss 能够最大化 $f(x)$ 和 $f(x^+)$ 互信息的下界,让二者的表示更为接近。理解了这个式子其实就理解了整个对比学习的框架,后续研究的核心往往就聚焦于这个式子的两个方面:

如何定义目标函数?最简单的一种就是上面提到的内积函数,另外一中 triplet 的形式就是 $l = max(0, η + s (x, x^+) - s (x, x^-))$ ,直观上理解,就是希望正例 pair 和负例 pair 隔开至少 $η$ 的距离,这一函数同样可以写成另外一种形式,让正例 pair 和负例 pair 采用不同的 $s$ 函数,例如, $s(x, x^+) = \| \max (0, f(x)-f(x^+)\|$ , $s(x, x^+) = \| \max (\eta, f(x)-f(x^-)\|$ 。如何构建正例和负例?针对不同类型数据,例如图像、文本和音频,如何合理的定义哪些样本应该被视作是 $x^+$,哪些该被视作是 $x^-$,;如何增加负例样本的数量,也就是上面式子里的 $N$ ?这个问题是目前很多 paper 关注的一个方向,因为虽然自监督的数据有很多,但是设计出合理的正例和负例 pair,并且尽可能提升 pair 能够 cover 的 semantic relation,才能让得到的表示在 downstream task 表现的更好。

来源:https://zhuanlan.zhihu.com/p/141141365

No 2. 《The Eyes Have It: An Integrated Eye and Face Model for Photorealistic Facial Animation》

这篇文章已发表于ACM Transactions on Graphics:https://doi.org/10.1145/3386569.3392493

眼球模型的实时单独渲染和与表情的组合似乎是它的优势

No 3. 《Deep Learning-based Computational Pathology Predicts Origins for Cancers of Unknown Primary》

No 4. *《The Art of Natural Language Processing: Classical, Modern and Contemporary Approaches to Text Document Classification :: SSRN》

No 5. *《NVAE: A Deep Hierarchical Variational Autoencoder》

No 6. 《A Survey on Recent Progress in the Theory of Evolutionary Algorithms for Discrete Optimization》

No 7. 《ReXNet: Diminishing Representational Bottleneck on Convolutional Neural Network》

No 8. 《Knowledge Distillation Beyond Model Compression》

No 9. 《LSTM and GPT-2 Synthetic Speech Transfer Learning for Speaker Recognition to Overcome Data Scarcity》

No 10. 《Learning Search Space Partition for Black-box Optimization using Monte Carlo Tree Search》

No 11. 《Transformers are RNNs: Fast Autoregressive Transformers with Linear Attention》

No 12. 具有周期激活函数的隐式神经网络表示

No 13. 《3D Topology Transformation with Generative Adversarial Networks》

No 14. 《Big Self-Supervised Models are Strong Semi-Supervised Learners》

No 15. 《Early-Learning Regularization Prevents Memorization of Noisy Labels》

No 16. 《How benign is benign overfitting?》

No 17. 《The Global Landscape of Neural Networks: An Overview》

No 18. 《Language-agnostic BERT Sentence Embedding》

No 19. *《SurVAE Flows: Surjections to Bridge the Gap between VAEs and Flows》

No 20. *《The Measure of Intelligence》

No 21. 《Validation and generalization of pixel-wise relevance in convolutional neural networks trained for face classification》

No 22. 《The Go Transformer: Natural Language Modeling for Game Play》

No 23. 《Graph Neural Network Based Coarse-Grained Mapping Prediction》

No 24. 《Approximate Nearest Neighbor Negative Contrastive Learning for Dense Text Retrieval》

No 25. 《Wiki-CS: A Wikipedia-Based Benchmark for Graph Neural Networks》

No 26. 《DeeBERT: Dynamic Early Exiting for Accelerating BERT Inference》

No 27. 《Collaborative Learning for Faster StyleGAN Embedding》

No 28. *《In Search of Lost Domain Generalization》

No 29. 《DeeBERT: Dynamic Early Exiting for Accelerating BERT Inference》

No 30. 《Federated Learning with Compression: Unified Analysis and Sharp Guarantees》

>

>