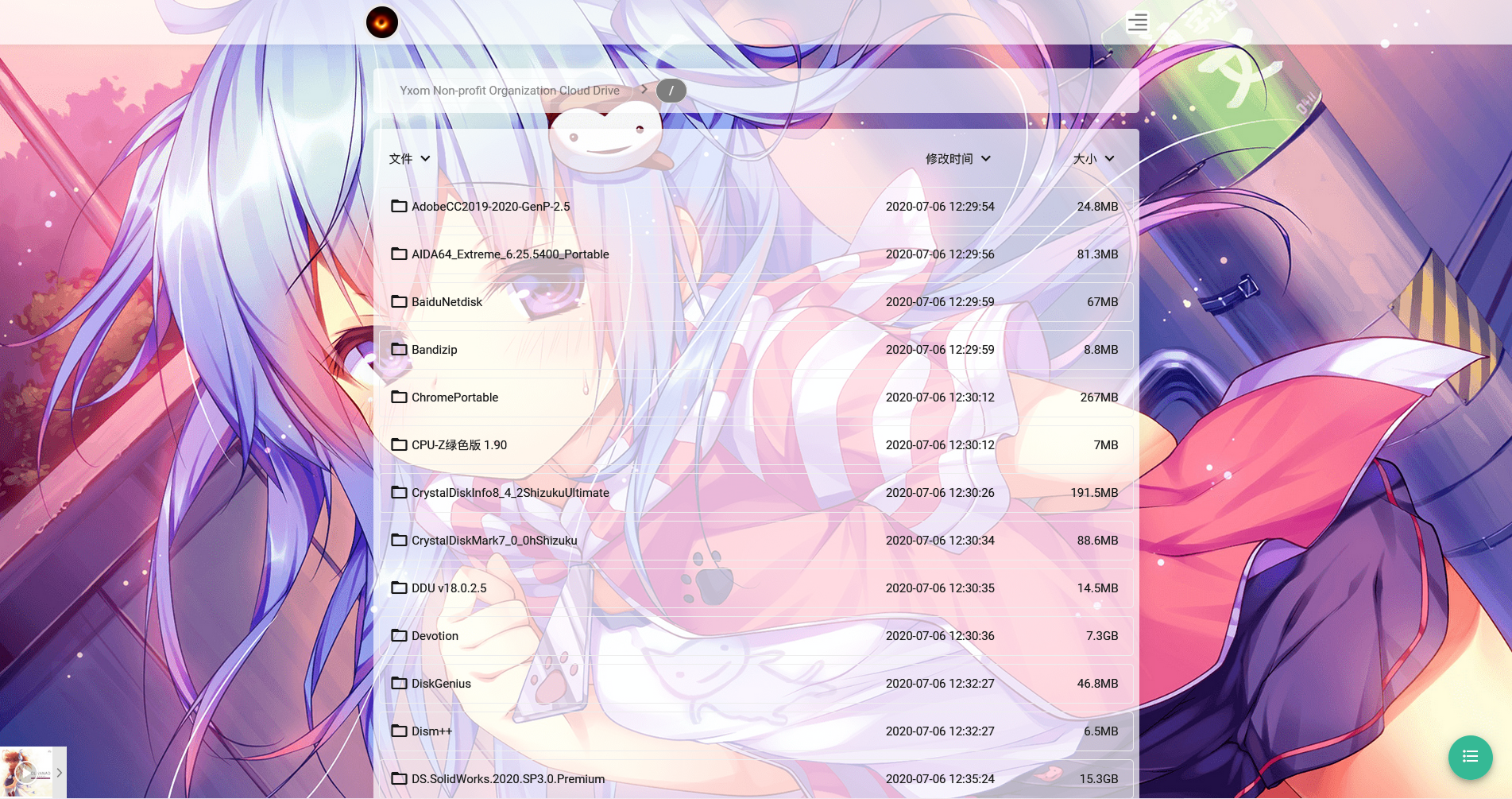

CSDS: Cloud Storage Distribute Service

鸣谢原作者

二次开发并使用的背景API,作者:小歪;

二次开发并使用的nexmoes模板,作者:dl233,遵循Apache 2.0 License;

二次开发并使用的OneIndex Bottle Edition,作者:SomeBottle;

二次开发并使用的OneIndex,作者:Donwa(现已删库);

使用wangziyingwen的AutoApiS项目进行续期;

使用字节跳动的西瓜播放器;

使用Mozilla的pdf.js;

二次开发和使用均已直接或间接获得授权。

最初想法

由于PanDownload事件,找一个安全且容量大的网盘似乎成了每个人的刚需,恰好想起来自己封存已久的Microsoft A1套餐——But I want more.

在万能的搜索引擎上得知Microsoft E5套餐的开发者版本,遂申请。(截止2022年2月已延期成功6次)

最初,列目录软件我使用了OneList(也是个不错的项目,基于Java),发现下载速度并不尽人意,二次开发也没有头绪,于是目光转向了OneIndex这个老牌的项目。

在国内高速访问,CDN 是必需的功能。事实上此功能的修改在onedrive.php内可以通过一句话实现。

应用场景

- 冷储存(储存稳定,容量大,上传下载速度也可以接受)

- 文件同步(2020年初Onedrive实现了差异同步,经vc加密的磁盘文件也可以快速同步)

- 图床(事实上,本站早期的图床就使用了OneIndexR)

- 文件分享和在线播放

仓鼠症的治疗方案

……

使用技巧

Onedrive客户端同步任意目录(或文件)——

原理:MKLINK创建目录(或文件)符号链接

CMD语法:MKLINK [[/D] | [/H] | [/J]] Link Target

说明:

/D 创建目录符号链接而不是文件符号链接(默认为文件符号链接)

/H 创建硬链接而不是符号链接

/J 创建目录连接点

Link 指定新的符号链接名称

Target 指定新链接引用的路径(绝对路径或者相对路径均可)

RaiDrive挂载Onedrive——

原理:通过Microsoft Graph API进行文件上下传操作

官网:https://www.raidrive.com/download

发展方向

优化缓存机制√、优化在线播放√、实现CDN加速上传、加快图床速度×、实现用量分析×、实现多用户盘×烂尾……

>

>